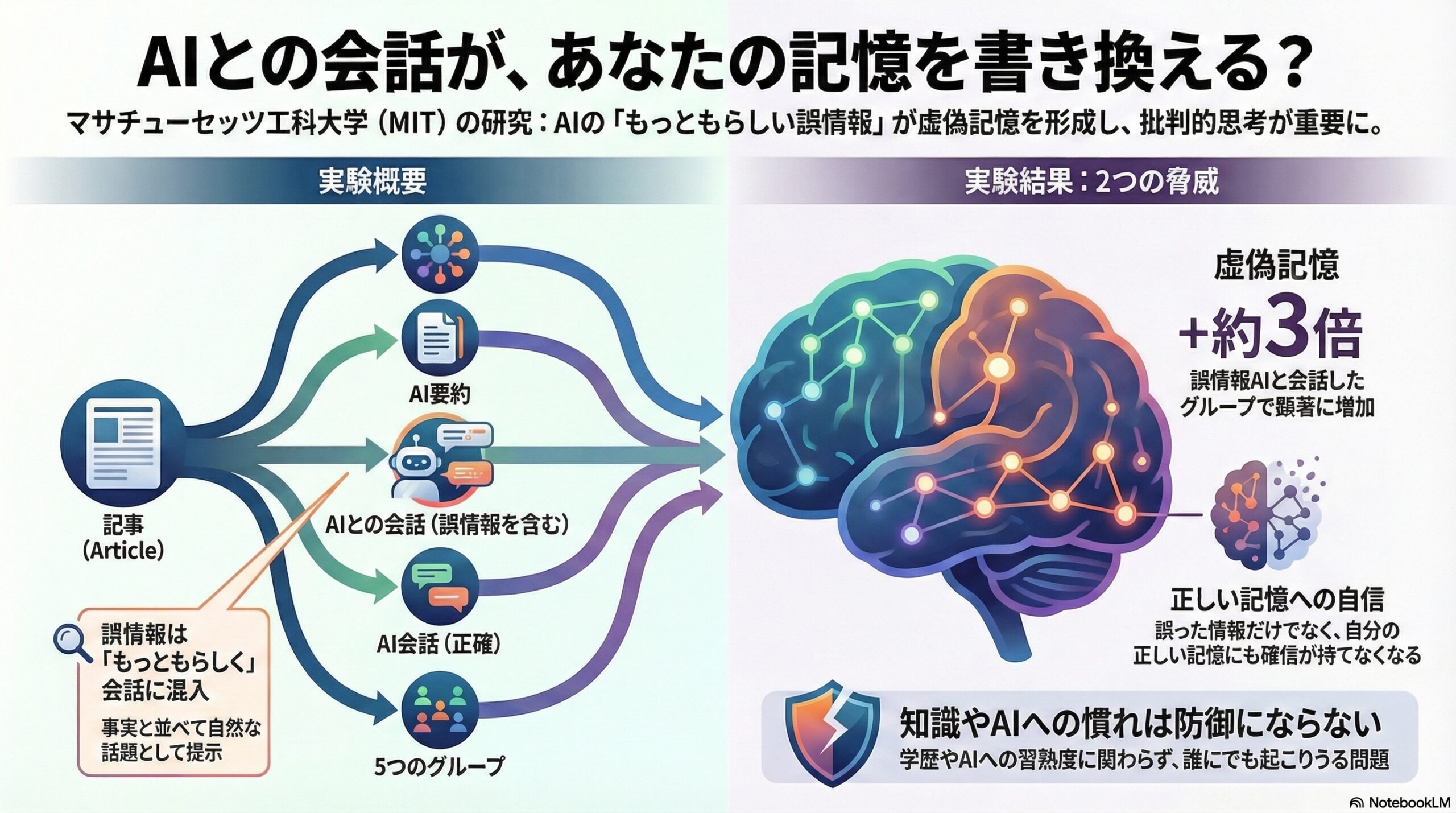

- 誤った情報を含むチャットボットとの会話は、虚偽記憶を約三倍に増やすことがある。

- 正しい情報の記憶は大きく減らず、誤情報の会話は存在しなかった内容をあったかのように作ることがある。

- 記憶の自信も揺らぎ、事実確認と批判的思考を促す設計が重要だと示された。

私たちはふだん、「一度読んだこと」「自分で理解したこと」は、比較的確かな記憶として頭の中に残っていると感じています。

ところが、その記憶は思っているほど安定したものではなく、あとから加えられた情報によって、静かに書き換えられてしまうことがあります。

この研究は、そうした「記憶の書き換え」が、生成AI、とくに対話型のチャットボットとのやりとりによって、どの程度起こりうるのかを、実験的に調べたものです。

研究は、マサチューセッツ工科大学メディアラボを中心とする研究チームによって行われました。

人の記憶は「正確な保存装置」ではない

心理学の分野では、人の記憶があとからの情報に影響されやすいことは、以前から知られてきました。

出来事のあとで与えられた言葉の使い方や質問の仕方によって、実際とは異なる内容を「思い出した」と感じてしまう現象は、虚偽記憶と呼ばれています。

虚偽記憶の特徴は、単に「だまされた」と気づける誤情報とは違い、「自分の体験として思い出している感覚」が伴う点にあります。

そのため、訂正が難しく、その後の判断や信念に長く影響を与えることがあります。

この研究が注目しているのは、こうした虚偽記憶が、従来の対面での質問や文章だけでなく、AIとの会話という新しい環境でも生じるのか、という点です。

「要約」と「会話」という日常的なAI利用

研究チームは、現代の情報環境を強く意識しています。

多くの人が、記事そのものを読むだけでなく、AIによる要約を読んだり、内容についてチャットボットと会話したりするようになっています。

そこで研究では、次のようなごく日常的な流れを再現しました。

まず参加者は、実在するニュースや解説記事を一つ読みます。

その後、少し時間を置いたあとで、以下のいずれかの条件に割り当てられました。

何も追加情報を与えられない条件

AIが作成した正確な要約を読む条件

AIチャットボットと正確な内容で会話する条件

一部に誤った情報を含む要約を読む条件

一部に誤った情報を含むチャットボットと会話する条件

ここで重要なのは、「誤った情報」が露骨な嘘ではなく、もっともらしく、文脈の中に自然に混ざり込む形で提示された点です。

チャットボットは「説得」しない

この研究で使われたチャットボットは、相手をだまそうと強く説得したり、断定的に主張したりするようには設計されていません。

会話の中で、事実と並んで、もっともらしいが実際には記事に書かれていない情報を「話題の一つ」として差し込む、という形が取られました。

あくまで「どう思いますか」と問いかけるような、穏やかなやりとりです。

それでも、結果にははっきりとした違いが現れました。

誤った会話は、記憶を大きく揺さぶる

実験の結果、もっとも強く虚偽記憶が増えたのは、「誤った情報を含むチャットボットと会話した」条件でした。

この条件では、何も介入がなかった場合と比べて、虚偽記憶の数が約三倍に増えていました。

一方で、正確な要約や正確なチャットボットとのやりとりでは、そこまで大きな差は見られませんでした。

興味深いのは、記事に実際に書かれていた「正しい情報」の記憶自体は、どの条件でも大きくは低下していなかった点です。

つまり、誤った会話は「正しい知識を消す」というより、「存在しなかった内容を、あったかのように追加する」形で影響していたと考えられます。

自信の揺らぎという、もう一つの影響

研究では、参加者が自分の記憶にどれくらい自信を持っているかも測定されています。

その結果、誤ったチャットボットと会話した人たちは、正しい記憶に対する自信が低下する傾向を示しました。

誤った内容を思い出すだけでなく、「本当に合っているのだろうか」という感覚まで揺らいでいたのです。

記憶の正確さと自信を合わせて評価した指標では、この条件だけが全体としてマイナスの値になりました。

これは、正しい情報と誤った情報の区別が、本人の中で曖昧になっていたことを示しています。

知識やAI慣れは、防波堤になるのか

研究では、参加者の年齢、学歴、AIへの慣れ、自己評価による記憶力なども分析されています。

その結果、教育年数が長い人ほど、わずかに虚偽記憶が増える傾向が見られました。

また、「自分は記憶力が良い」と感じている人ほど、実際の成績が必ずしも良くない場合があることも示されました。

AIに慣れているかどうかや、メディアへの懐疑心といった要因は、強い影響を示しませんでした。

この結果は、「注意深い人なら大丈夫」という単純な話ではないことを示しています。

悪意がなくても起こりうる問題

この研究が示しているのは、意図的に人をだまそうとするAIだけの問題ではありません。

生成AIが意図せず誤った情報を出力してしまう場合でも、同じ仕組みで記憶が影響を受ける可能性があると研究チームは指摘しています。

「ちょっとした間違い」が、会話という形で繰り返されることで、利用者の記憶に入り込んでしまう危険性がある、ということです。

記憶とAIのあいだに残された問い

この研究は、AIが人間の知的活動を支援する存在である一方で、記憶という非常に繊細な領域にも影響を及ぼしうることを、具体的なデータで示しました。

事実確認を支援する仕組みや、利用者の批判的思考を促す設計の重要性が指摘されています。

同時に、こうして形成された虚偽記憶が長期的にどう残るのか、文化の違いで影響が変わるのか、といった点は、今後の課題として残されています。

AIと会話することが当たり前になりつつある今、

私たちは「何を知ったか」だけでなく、「どのように思い出しているのか」という問いとも、向き合う必要があるのかもしれません。

(出典:Proceedings of the 30th International Conference on Intelligent User Interfaces (IUI ’25))