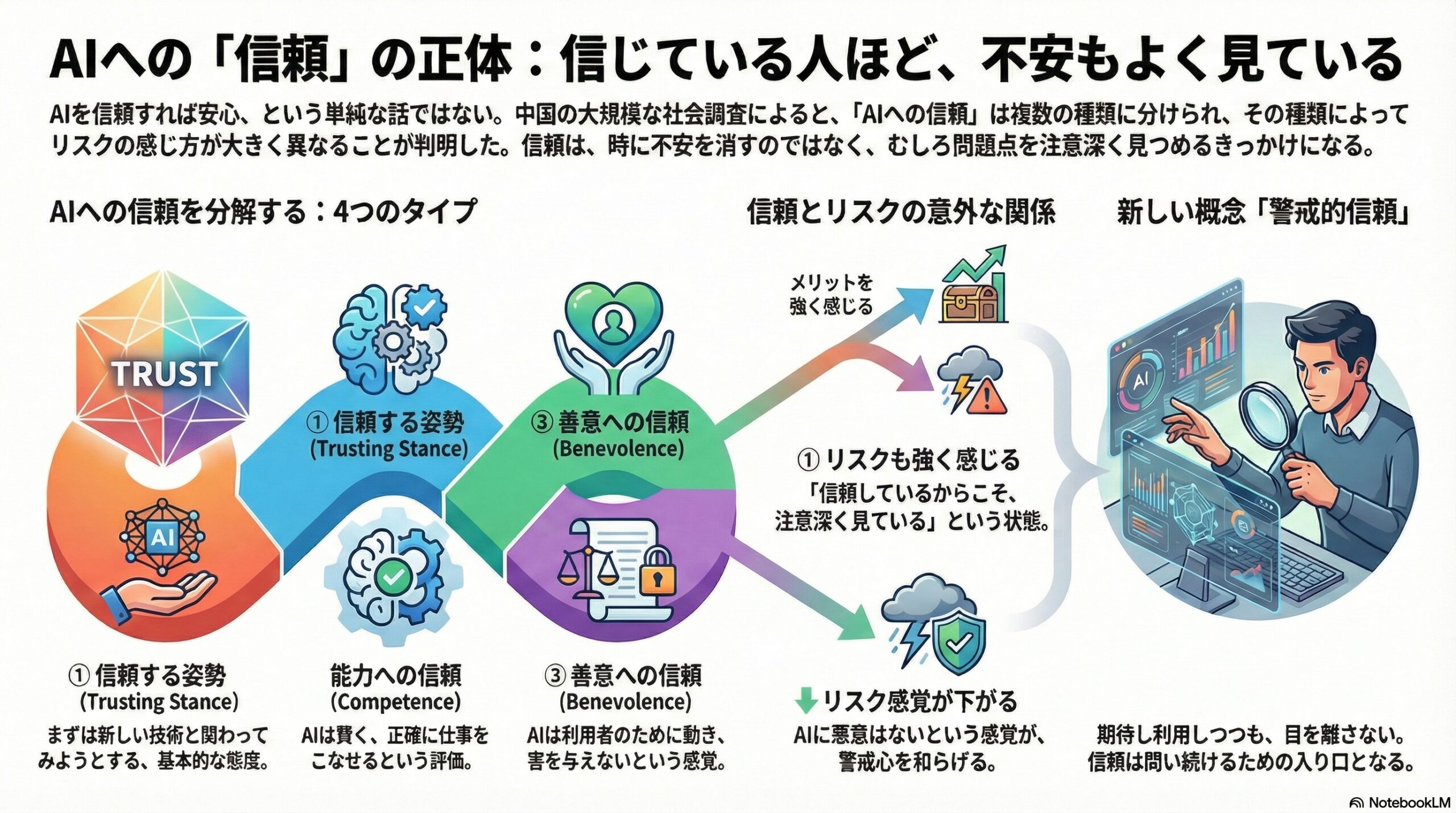

- 中国の全国調査を使って、AIへの信頼を「姿勢・能力・善意・誠実さ」の4つに分けて調べた。

- 信頼が高いほどメリットは感じるが、リスク感覚が必ずしも弱まるわけではなく、信頼する姿勢の人は特にリスクも強く感じることがある。

- 警戒的信頼という考え方のもと、便利さを認めつつ問題点を見続けることで、リスクを知ることが受容につながる可能性があると指摘される。

信頼すれば、怖くなくなる、は本当でしょうか

AIを信頼している人は、AIのリスクをあまり感じなくなる。

この考え方は、これまで多くの研究や政策議論の前提になってきました。

しかし、私たち自身の感覚を振り返ると、どこか引っかかるところがあります。

AIに期待している人ほど、「便利そうだけど、ちょっと怖い」「すごい技術だからこそ、心配もある」と感じていることはないでしょうか。

この論文は、その違和感を正面から扱っています。

中国の全国調査データを用い、「AIへの信頼」は本当にリスク感覚を弱めるのか、それとも別の働きをしているのかを丁寧に検証しました。

研究を行った組織とデータの規模

この研究は、中国社会科学院(Chinese Academy of Social Sciences)を中心に、

温州医科大学(Wenzhou Medical University)、上海交通大学(Shanghai Jiao Tong University)などの研究者によって行われました。

用いられたのは、中国社会心理調査(Chinese Social Mentality Survey)という、

31の省・自治区・直轄市を対象にした全国代表サンプルの対面調査です。

分析に用いられた有効回答は1万人以上。

オンライン調査ではなく、家庭訪問による聞き取り調査である点も、この研究の信頼性を支えています。

「信頼」をひとつにまとめてはいけない

この研究の大きな特徴は、「信頼」をひとつの気持ちとして扱っていない点にあります。

研究では、AIに対する信頼を次の4つに分けています。

まず一つ目は、**信頼する姿勢(トラスティング・スタンス)**です。

これは、「よくわからなくても、とりあえず新しい技術と関わってみよう」とする基本的な態度を指します。

二つ目は、**能力への信頼(コンピテンス)**です。

AIは賢く、正確に仕事をこなせる存在だと思っているかどうか、という評価です。

三つ目は、**善意への信頼(ベネボレンス)**です。

AIは利用者のために動き、害を与えようとはしない存在だと感じているか、という点です。

四つ目は、**誠実さへの信頼(インテグリティ)**です。

AIはルールや倫理、公平性を守って動くはずだ、という期待です。

これらは似ているようで、心理的にはかなり異なる働きをします。

信頼が高い人ほど、メリットはよく見える

分析の結果、まずはっきりしたことがあります。

どのタイプの信頼であっても、AIの「良い点」は強く感じるようになる、という点です。

便利になる。

効率が上がる。

社会全体に役立つかもしれない。

こうしたメリットの認識は、AIを受け入れるかどうかを決めるうえで、最も強い要因でした。

これは直感的にも納得しやすい結果です。

しかし「信頼=安心」ではありませんでした

ここからが、この研究の核心です。

AIを信頼している人ほど、リスクを感じなくなる。

この単純な関係は、実際には成り立っていませんでした。

特に興味深いのは、「信頼する姿勢」が強い人の特徴です。

このタイプの人は、

AIのメリットも、リスクも、どちらも強く感じていました。

つまり、

「信頼しているから、心配しない」のではなく、

「信頼しているからこそ、よく見ている」という状態です。

「善意」だけは、リスク感覚を下げていました

一方で、信頼の種類によっては、リスクの感じ方が変わるものもありました。

AIは人のために動く存在だ、という善意への信頼が高い人は、

プライバシー侵害や悪用といったリスクを、比較的低く見積もる傾向がありました。

裏切られない、悪意はない、という感覚が、警戒心を和らげていると考えられます。

ただし、ここでも重要なのは、

「すべての信頼がリスクを下げるわけではない」という点です。

能力が高いと思うほど、怖くなることもある

AIの能力を高く評価している人は、

メリットを強く感じる一方で、リスクについては一貫した傾向を示しませんでした。

場合によっては、

「そんなに賢いなら、影響も大きいのではないか」

「制御できなくなったらどうなるのか」

と、不安が強まることもありました。

強さや有能さは、安心にも、不安にもつながるのです。

リスクを感じていても、人はAIを受け入れる

さらに意外な結果があります。

この研究では、

AIのリスクを強く感じている人ほど、AIを受け入れない、

という単純な関係は見られませんでした。

むしろ一部では、

リスクをよく理解している人ほど、AIを受け入れている、

という正の関係すら確認されています。

これは、「危険だと思っているのに使う」という矛盾ではありません。

「警戒的信頼」という考え方

研究者たちは、この状態を**警戒的信頼(ヴィジラント・トラスト)**と呼びます。

警戒的信頼とは、

無条件に信じることでも、

すべてを疑うことでもありません。

使う。

期待する。

しかし同時に、目を離さない。

便利だと感じながら、

問題点にも意識を向け続ける。

この論文は、人々がAIと向き合うとき、

このような複雑で成熟した態度をとっていることを示しています。

なぜ「リスクを知ること」が受容につながるのか

研究では、いくつかの可能性が示唆されています。

ひとつは、

リスクを理解している人ほど、AIについて深く考え、主体的に向き合っているという可能性です。

もうひとつは、

メリットが非常に大きいと感じている場合、

「危険はあるが、それでも使う」という判断が自然に成立するという点です。

さらに、

国や制度が管理してくれるだろう、という前提があると、

個人レベルの不安は受容の妨げになりにくくなる、という側面もあります。

この研究が問いかけていること

この論文が投げかけているのは、

「信頼を高めれば、不安は消える」という単純な発想への疑問です。

人は、

安心したから考えなくなるのではなく、

信頼しているからこそ、考え続けることがあります。

AIをめぐる社会的な議論においても、

不安を消すことより、

不安を含んだまま、考え続けられる関係をどう作るかが重要なのかもしれません。

信じながら、目を離さないという態度

この研究が描いている人々の姿は、

決してナイーブでも、過度に楽観的でもありません。

AIを信じる。

しかし、委ねきらない。

期待する。

しかし、盲信しない。

その姿は、

「AIに慣れていく社会」が成熟していく過程そのものにも見えます。

信頼とは、安心の終点ではなく、

問い続けるための入り口なのかもしれません。

(出典:Behavioral Sciences)