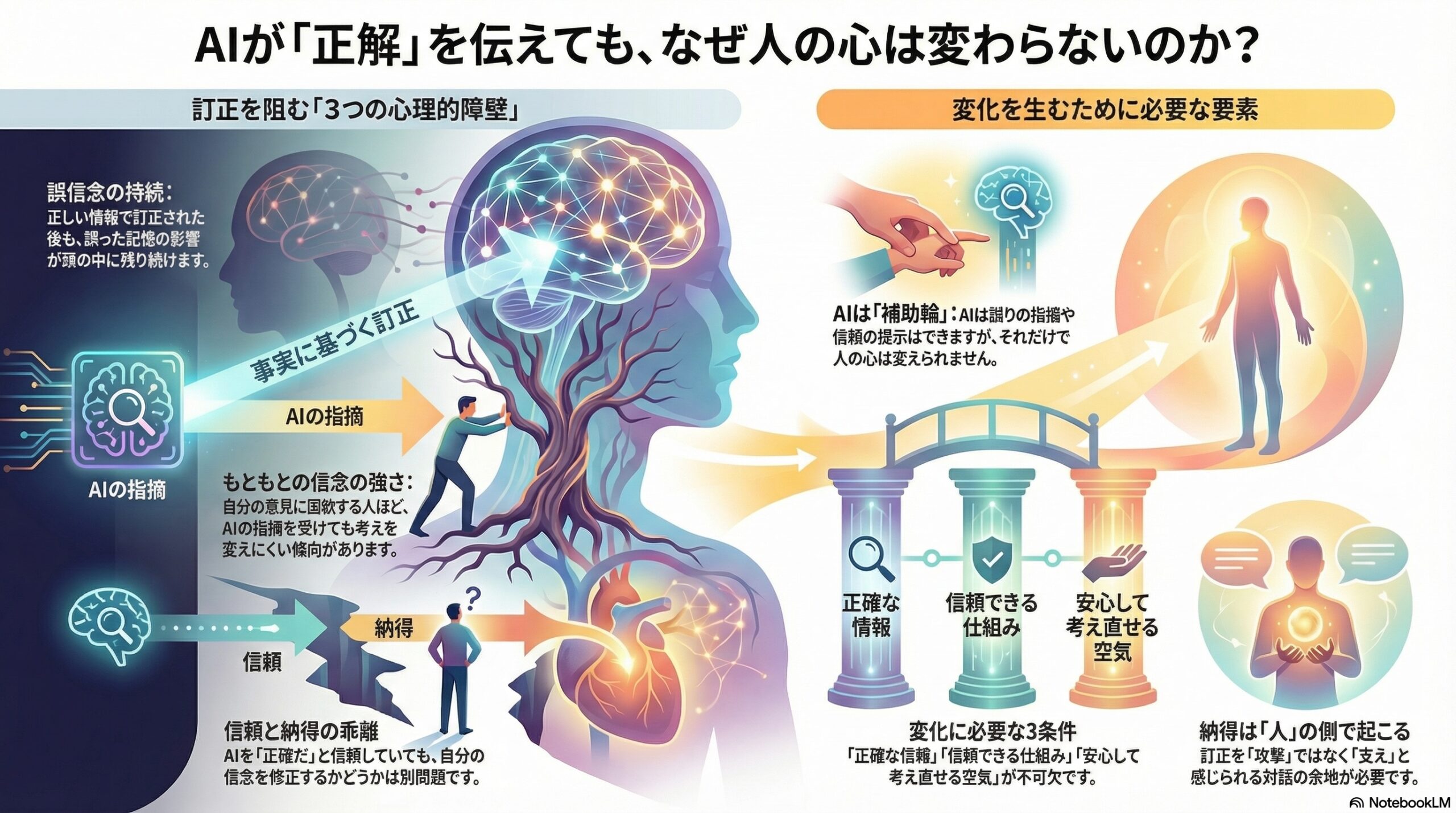

- AIに訂正されても、誤情報の影響が頭の中に残ることが多い。

- 元々の信念が強いほど、訂正の効果は出にくい。

- AIを信頼しても、考えの修正は必ずしも起きない。

AIは、人の考えを変えられるのか

今回紹介する研究は、アメリカのオハイオ州立大学を中心に、サム・ヒューストン州立大学やヴァンダービルト大学などの研究者によって行われました。

この研究は、「AIによる自動ファクトチェックが、人の考えをどの程度変えられるのか」という、現代社会にとって重要な問いを扱っています。

私たちは毎日、ネット上で膨大な情報に触れています。

ニュース、SNS、動画、コメント欄。

そこには正しい情報もあれば、間違った情報も混ざっています。

近年、その問題に対処する手段として、「ファクトチェック」が広く使われるようになりました。

事実かどうかを確認し、誤りであれば訂正する。

一見すると、それで問題は解決しそうに見えます。

しかし、この研究は、そこに一つの疑問を投げかけます。

訂正されたとき、人は本当に考えを変えているのか。

間違いだと知っても、信じ続けてしまう理由

人は、

「それは間違いです」と言われたからといって、

すぐに考えを切り替えられるとは限りません。

頭では理解していても、

心のどこかで元の考えを引きずってしまう。

心理学では、このような現象を「誤信念の持続」と呼ぶことがあります。

間違いだと分かっても、その影響が残り続ける状態です。

この研究は、まさにこの点に注目しています。

研究の中心にある三つの要素

研究者たちは、次の三つがどのように関係するのかを調べました。

-

もともと持っている信念の強さ

-

AIに対する信頼の度合い

-

AIの正確性について事前に知らされているかどうか

そして、その結果として、

-

誤情報をどれくらい信じ続けるのか

-

訂正してきたAIをどれくらい信用するのか

がどう変化するかを測定しました。

実験で行われたこと

参加者は、社会問題に関する短い文章を読みます。

その中には、あえて誤った情報が含まれています。

その後、参加者の一部には、

AIによる「この情報は間違っています」という訂正が提示されました。

さらに条件によって、

-

このAIはとても正確だと説明される場合

-

正確性について何も説明されない場合

に分けられました。

研究者たちは、その後の参加者の考え方の変化を調べました。

わかったこと①

訂正されても、影響は残る

AIから訂正を受けた人は、多くの場合、

誤情報を以前ほどは信じなくなりました。

しかし、

完全に信じなくなる人は少数でした。

つまり、

間違いだと分かっても、誤情報の影響は頭の中に残る

ということです。

わかったこと②

もともとの信念が強いほど、変わりにくい

話題について、もともと強い意見を持っていた人ほど、

AIの訂正を受けても考えを変えにくい傾向がありました。

人は、自分の考えと合う情報を好み、

合わない情報を無意識に避けやすい傾向があります。

この性質が、訂正の効果を弱めていると考えられます。

わかったこと③

AIへの信頼と、考えの修正は別物

AIについて「正確なシステムです」と説明されると、

参加者はそのAIをより信頼するようになりました。

しかし、ここで重要なのは、

AIを信頼していても、必ずしも考えを大きく変えるわけではない

という点です。

信頼と信念の修正は、同じものではありません。

誤情報問題は、技術だけでは解決しない

この研究は、誤情報の問題を

「正確なツールを作れば解決する」

という単純な話として扱っていません。

人の考えは、

-

感情

-

価値観

-

自己イメージ

-

これまでの経験

と深く結びついています。

だからこそ、訂正情報がどれだけ正しくても、

簡単には受け入れられない場合があります。

AIは「補助輪」にはなれる

研究が示しているのは、

AIは無力だ、ということではありません。

AIは、

-

誤りを指摘する

-

正しい情報を提示する

といった役割を果たすことはできます。

ただし、

それだけで人の考えを根本から変えることは難しい

という現実も同時に示されています。

変化が起きるために必要なもの

この研究から浮かび上がるのは、次のような視点です。

-

正確な情報

-

信頼できる仕組み

-

安心して考え直せる空気

この三つがそろって、はじめて変化が生まれます。

訂正が「攻撃」に感じられると、人は心を閉ざします。

訂正が「支え」に感じられると、人は少しずつ考え直します。

私たち自身への問い

この研究は、AIの性能を評価するだけのものではありません。

むしろ、

私たちは、

間違いを指摘されたとき、

どんな態度でそれを受け取っているのか。

そして、

他人の間違いに出会ったとき、

どんな伝え方をしているのか。

そうした姿勢そのものを問いかけています。

結論を閉じすぎないという選択

AIは「正しさ」を示すことはできます。

しかし、「納得」や「受け入れ」は、人の側で起こります。

この研究は、

テクノロジーが進んでも、

人間の心の複雑さは変わらないことを、静かに示しています。

そして同時に、

だからこそ、対話の余地はまだ残っている。

そんな余白を残す研究だと言えるのかもしれません。

(出典:PLOS One DOI: 10.1371/journal.pone.0342332)