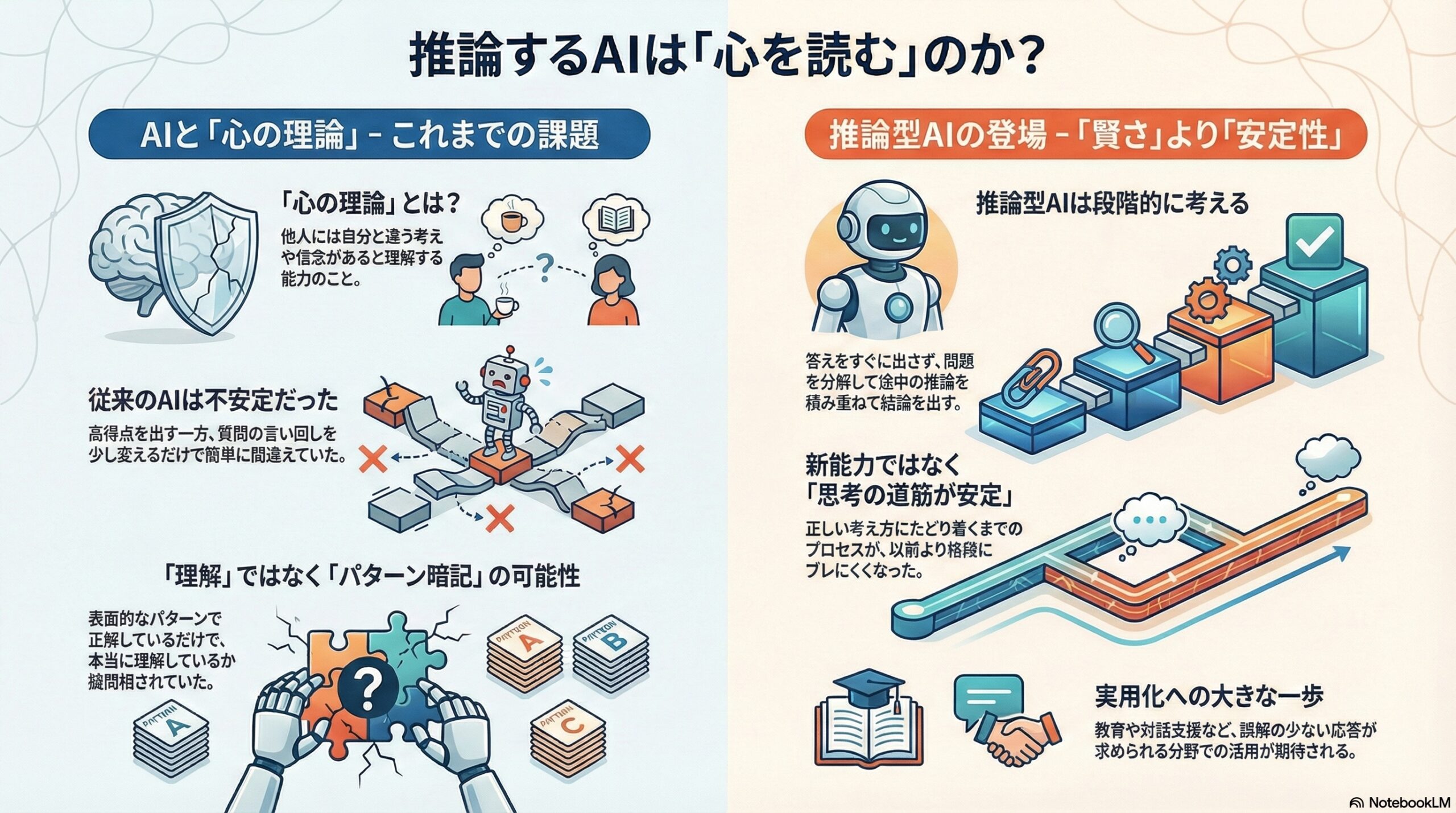

- 推論型AIは新しい心の理論を得たのではなく、考え方の道筋がより安定して使えるようになった。

- 誤信念課題やストーリー課題で高得点を出し、推論モードありのほうが安定して正解しやすい。

- 教育や対話、カウンセリング補助など、心を扱う場面で失敗しにくい道具になりつつある。

それとも、答えを見つけるのが上手くなっただけなのか

私たちは日常の中で、相手が「何を考えているか」「何を信じているか」「どう感じているか」を想像しながら生きています。

このように、他者の心の状態を推測する能力は、心理学では**心の理論(Theory of Mind:トゥーマインド)**と呼ばれています。

近年、大規模言語モデルと呼ばれるAIが、こうした「心を読む」能力を試すテストで高い成績を出すようになり、「AIは本当に心の理論を持ち始めているのではないか」という議論が起きています。

一方で、最近登場した「推論型AI(reasoning model)」と呼ばれるモデルは、答えを出す前に内部で考える過程を重ねるよう訓練されています。

この研究は、推論型AIが心の理論課題で良い成績を出す理由は何なのかを詳しく調べています。

結論から言えば、研究者たちは次のように考えています。

推論型AIは、新しい「心を理解する能力」を獲得したというよりも、

もともと持っていた能力をより安定して発揮できるようになった可能性が高い。

この記事では、その意味を丁寧に見ていきます。

心の理論とは何か

心の理論とは、

-

他人には自分とは違う考えや信念がある

-

その信念が間違っている場合でも、その人はその信念に基づいて行動する

ということを理解する力です。

代表的なテストとして**誤信念課題(フォールスビリーフテスト)**があります。

これは、「現実」と「登場人物が信じている内容」が食い違う状況を理解できるかを調べます。

子どもはおおよそ4歳前後から、このような課題に正しく答えられるようになることが知られています。

これまでのAIと心の理論研究

過去の研究では、

-

2023年頃のAIは、7〜10歳の子どもより低い成績を示す場合がある

-

一方で、高性能なモデルは、大人に近い成績を示すこともある

と報告されてきました。

しかし同時に、

-

問いの言い回しを少し変えるだけで急に間違える

-

表面的なパターン暗記で解いているだけではないか

という批判もありました。

つまり、「正解すること」と「理解していること」は別かもしれない、という問題です。

推論型AIとは何か

推論型AIは、答えをすぐに出すのではなく、

-

問題を分解する

-

途中の推論を積み重ねる

-

最後に結論を出す

という形式で学習されています。

この仕組みは、**強化学習と検証可能な報酬(RLVR)**と呼ばれる方法で訓練されています。

重要な点は、先行研究により、

推論型AIは「まったく新しい能力」を得ているわけではなく、

すでに可能だった解き方を、より効率的に見つけているだけ

と示されていることです。

この研究で行われたこと

ライデン大学の研究チームは、複数の推論型AIと非推論型AIに対して、心理学で使われてきた心の理論テストを実施しました。

主に用いられた課題は次のようなものです。

-

一次・二次のサリー・アン課題(誤信念課題)

-

ストレンジストーリー課題(皮肉・冗談・嘘・二重ブラフなど)

-

インポージングメモリー課題(複数人物の信念を記憶しながら判断)

-

文章を少し改変した心の理論課題

そして、正答だけでなく推論の内容も評価しました。

結果①:ほとんどの基本課題で高得点

一次・二次の誤信念課題では、ほぼすべてのモデルが正解しました。

これは、2023年頃の研究よりも明らかに高い成績です。

ただし研究者たちは、

この課題は有名すぎるため、

パターンとして学習されている可能性もある

と慎重な見方も示しています。

結果②:皮肉や二重ブラフもほぼ理解

ストレンジストーリー課題では、

-

嘘

-

ごっこ遊び

-

冗談

-

思いやりのある嘘

-

誤解

といった話は、ほぼ完璧に処理できました。

皮肉や二重ブラフでは一部のモデルが迷う場面がありましたが、多くの場合、複数の可能性を検討したうえで判断していました。

結果③:推論ありのほうが安定する

同じモデルで、

-

推論モードあり

-

推論モードなし

を比較すると、推論ありのほうが成績が良いケースが確認されました。

特に、文章をわざと紛らわしくした課題では差が大きくなりました。

見えてきた重要なポイント

研究チームは、ここから次のように解釈します。

推論型AIは、

心を理解する「新しい回路」を獲得したのではなく、

正しい考え方にたどり着くまでの道筋が安定した。

つまり、

-

以前のAIも「解ける能力」は持っていた

-

しかし、ちょっとした表現の違いで道を踏み外していた

-

推論型AIは、踏み外しにくくなった

ということです。

「理解している」とはどういうことか

この研究は、哲学的な意味で

-

AIに本当の心があるか

-

意識があるか

といった問題には踏み込みません。

代わりに、

外から見て、その能力が安定して使えるか

という立場を取ります。

つまり、

-

人間と同じように振る舞えるなら

-

実用上は「持っている」とみなす

という考え方です。

なぜ視覚的な想像が関係するのか

モデルが失敗しやすかった課題の多くは、

-

透明な箱

-

物が「中」ではなく「上」にある

といった空間的な想像が必要なものでした。

人間は自然に頭の中で情景を思い浮かべますが、AIは主に言語情報に頼っています。

研究者たちは、

言葉だけで状況を組み立てるのは、

私たちが思う以上に難しい

と指摘しています。

この研究が示す意味

この研究は、次のことを示唆しています。

-

AIは急に「心を持った」わけではない

-

しかし、人の心を扱う問題を、安定して解ける方向に進化している

これは実用面では大きな変化です。

-

教育支援

-

対話支援

-

カウンセリング補助

など、誤解が少ない応答が求められる場面で重要になります。

まとめ

ライデン大学の研究は、

推論型AIの強みは「賢くなった」ことより、

「ブレにくくなった」ことにある

と結論づけています。

AIは、心を持つ存在になったわけではありません。

しかし、人の心を扱う問いに、より安定して向き合える道具になりつつある。

この変化は静かですが、確実に積み重なっています。

私たちは今、

「考える機械」が、より失敗しにくい形で考える時代に入りつつあるのかもしれません。

(出典:arXiv DOI: 10.48550/arXiv.2601.16853)