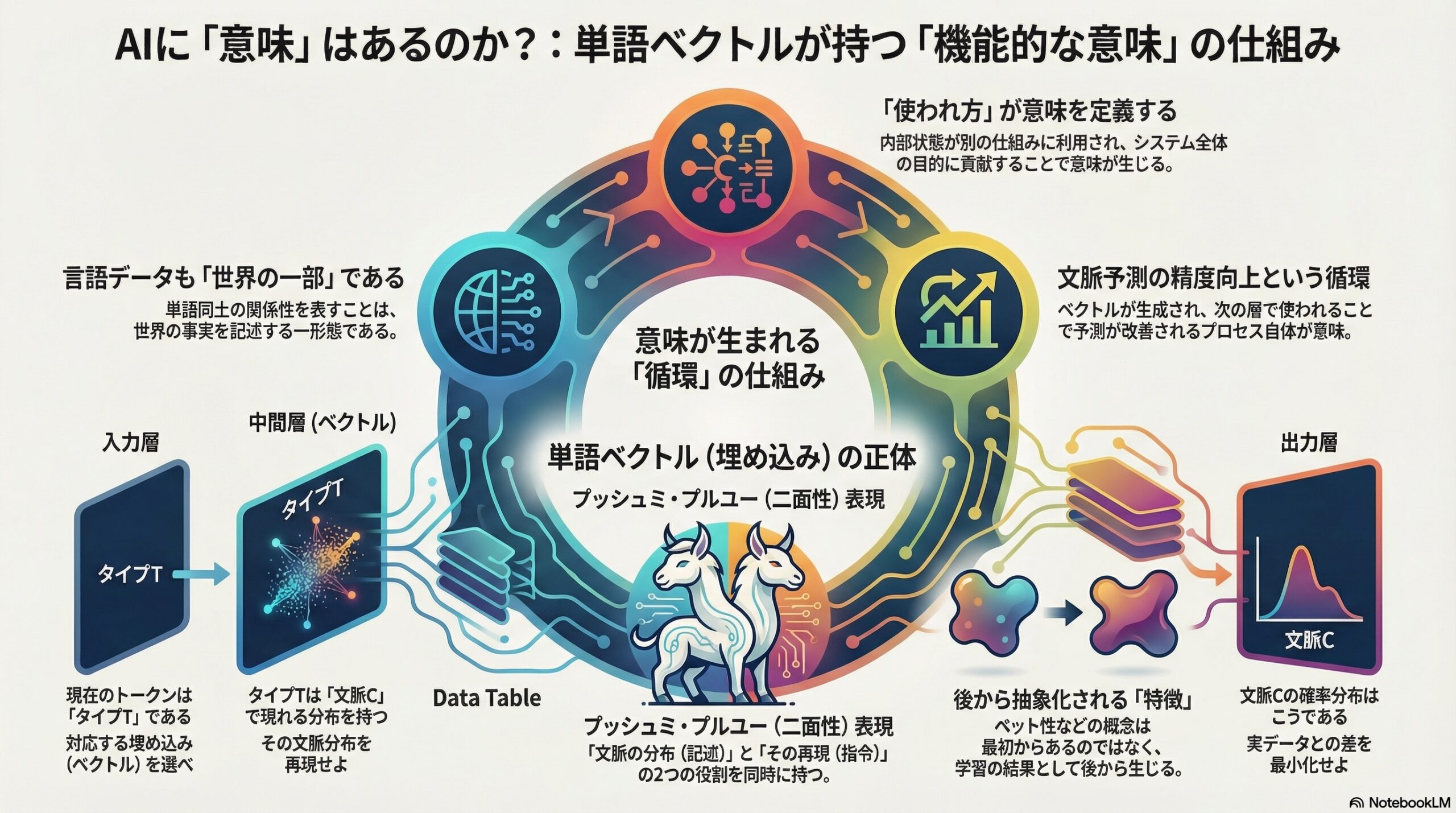

- 単語ベクトルは「この単語がどう使われるか」という文脈の分布を表しているだけで、単語そのものを直接表しているわけではない。

- それはネットワーク内で生成され、次の層で使われて文脈予測を改善する循環の中で意味を持つとされ、プッシュミ・プルユー表現として記述と指示の二つの役割を持つ。

- AIの意味は人間の意味と同じではないが、使われ方の中に機能的な意味が生まれる可能性があると議論されている。

私たちが日常的に使っている言葉は、ただの記号の集まりではありません。

「ネコ」「イヌ」「王」「女王」といった言葉は、それぞれ何らかの意味を持ち、状況に応じて使い分けられています。

一方で、近年の人工知能(AI)、とりわけ自然言語処理に用いられるニューラルネットワークは、「意味」を理解しているように見えるふるまいを示します。

たとえば、「王 − 男 + 女 ≒ 女王」といった計算が可能な単語ベクトル(ワードエンベディング)は、その象徴的な例です。

では、こうした内部表現は、本当に「意味」を持っているのでしょうか。

それとも、私たちが便宜的に意味があるように解釈しているだけなのでしょうか。

この問いに対して、イギリスのダラム大学哲学部を拠点とする研究者による論文は、「目的論的意味論(テレオセマンティクス)」という哲学的枠組みを用いて、ニューラルネットワーク内の単語ベクトルがどのような意味を持ちうるのかを詳細に検討しています。

以下では、その議論をできるだけ平易な形で紹介します。

ニューラルネットワークは「意味」を持てるのか

まず前提として、この研究は次の問いから出発します。

「人工ニューラルネットワークは、人間の脳のように“本物の意味”を持つ表現を内部に形成できるのか。」

単に研究者が「これはネコを表している」とラベルを貼るだけでは不十分です。

重要なのは、その内部状態が、システム自身の働きの中で、意味を持つ役割を果たしているかどうかです。

ここで用いられるのが、消費者ベースのテレオセマンティクスという立場です。

この考え方では、表現の意味は、

「その表現が、どのような仕方で使われているか」

によって決まります。

つまり、ある内部状態が、別の仕組みによって利用され、その利用がシステム全体の目的に貢献しているなら、その内部状態は意味を持つと考えます。

単語ベクトルとは何か

単語ベクトルとは、単語を数百次元程度の数値の並びとして表現したものです。

word2vec などのアルゴリズムでは、

-

入力としてある単語を与える

-

その周囲に出やすい単語を予測させる

という学習を繰り返します。

結果として、

-

「ネコ」と「イヌ」は近い位置

-

「ネコ」と「テーブル」は遠い位置

に配置されます。

さらに、ベクトル同士の足し引きによって、関係性まで表現できることが知られています。

重要な視点:表現は「使われ方」で意味を持つ

この論文の核心は次の点です。

単語ベクトルは、

「単語そのもの」を表しているのではなく、

その単語がどのような文脈で使われるかという分布の事実を表している。

つまり、単語ベクトルの内容は、

「この単語は、こういう種類の単語と一緒に出やすい」

という事実です。

ここで重要なのは、単語ベクトルが単独で意味を持つのではなく、

-

生成され

-

次の層で利用され

-

その結果として文脈予測が改善される

という循環の中で意味を獲得している点です。

プッシュミ・プルユー表現

研究では、単語ベクトルをプッシュミ・プルユー表現と呼ばれるタイプの表現として位置づけます。

これは、

-

何が起きているかを示す(記述的側面)

-

何をすべきかを指示する(指令的側面)

の両方を同時に持つ表現です。

単語ベクトルの場合、

-

記述的側面

→「この単語は、このような文脈分布を持つ」 -

指令的側面

→「この分布を出力層で再現せよ」

という二重の役割を果たします。

各層の役割を整理すると

論文では、ネットワーク内の三種類の表現が区別されます。

-

入力のワンホット表現

-

記述:今のトークンはタイプTである

-

指令:対応する埋め込みを選べ

-

-

単語ベクトル(埋め込み)

-

記述:タイプTの単語は文脈Cで現れる

-

指令:その文脈分布を生成せよ

-

-

出力ベクトル

-

記述:文脈Cの確率分布

-

指令:この分布と実データの差を小さくせよ

-

この構造によって、単語ベクトルは単なる数値ではなく、システム内で機能する意味的表現になります。

特徴(ペット性など)はどこから来るのか

人間は単語ベクトルを分析すると、

-

PET(ペット)

-

SMALL(小さい)

-

ANIMAL(動物)

のような特徴が潜んでいるように見えます。

研究は、こうした特徴が最初から意味として存在するわけではないと指摘します。

むしろ、

-

あるニューロンの活動が

-

特定の入力単語群と

-

特定の出力単語群を結びつける

ように学習された結果として、

「ペット的な性質を持つ語」

というまとまりが生じます。

つまり、特徴の意味は、単語ベクトル全体の役割から後から抽象されるものです。

単語ベクトルは世界を表していないのか

一部の哲学者は、

「言語データだけで学習したモデルは、現実世界を表していない」

と主張します。

これに対し本研究は、

言語そのものも世界の一部である

と反論します。

単語と単語の関係を表すことも、世界の事実を表す一形態だという立場です。

この研究が示す重要な視点

この論文は、次のような考え方を示しています。

-

単語ベクトルは、

便宜的に解釈されているだけの数字ではない -

ネットワーク内部で

生成され、使われ、評価される

という役割の中で意味を持つ -

その意味は、

「単語がどの文脈で使われるか」という事実に関するもの

AIが人間と同じ意味を理解しているとは言えません。

しかし、「まったく意味を持たない」と切り捨てるのも正しくない。

その中間にある、限定的で機能的な意味の存在を、この研究は示しています。

私たちはしばしば、「AIは理解していない」「AIはただ計算しているだけだ」と言います。

しかし、この研究は問いを少しずらします。

計算しているからこそ、意味が生まれているのではないか。

意味とは、頭の中の神秘的な何かではなく、

「使われ方の中で形成されるもの」なのかもしれません。

この視点は、AIの理解だけでなく、

人間の心を考える上でも、静かな示唆を与えてくれます。

(出典:PhilArchive)