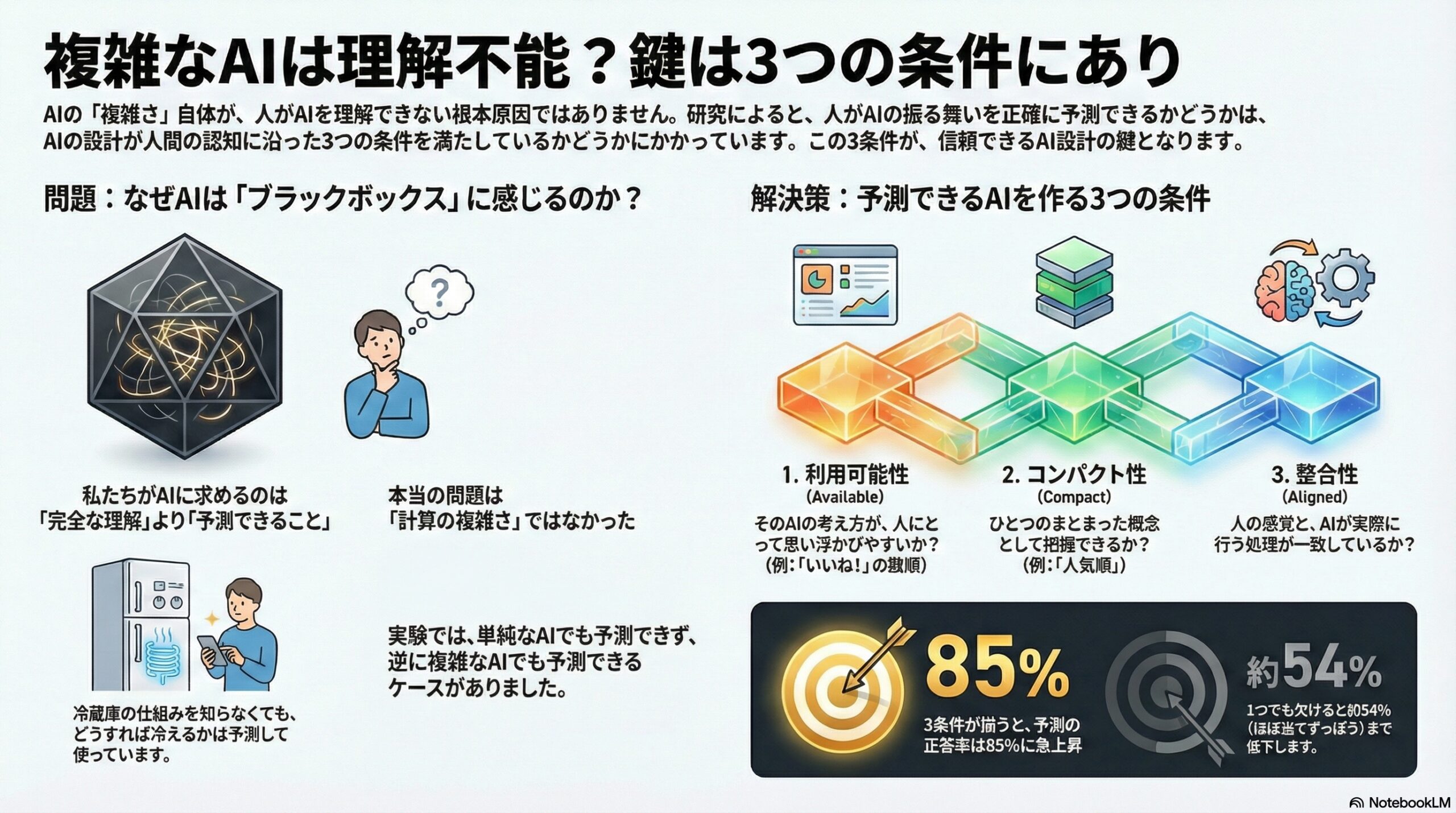

- 複雑な仕組みを知ることよりも、振る舞いを予測できることが信頼につながる。

- 予測可能になる三条件は、利用可能性・コンパクト性・整合性の三つである。

- 三条件をすべて満たすと正答率は約85%、どれかが欠けると約54%になる。

人は「複雑なアルゴリズム」でも理解できるのか

――予測できるAIに必要な三つの条件

私たちは日常的に、多くのアルゴリズムとともに生きています。

ソーシャルメディアのフィード、動画のおすすめ、検索結果、広告、就職や融資の判断支援。

こうした場面で、しばしば聞かれるのが次のような感覚です。

「なぜ、この投稿が表示されたのか分からない」

「このAIは、何を基準に判断しているのだろう」

「自分が何をすれば結果が変わるのか見えない」

スタンフォード大学とドイツのハッソ・プラットナー研究所の研究チームは、この問題を正面から扱いました。

そして、ある重要な問いを立てます。

人は、本当に“複雑なアルゴリズム”を理解できないのか。

研究の結論は、意外なものでした。

複雑かどうかは、本質ではない。

ある条件を満たせば、人は高度なAIのふるまいでも正確に予測できる。

予測できることが「信頼」につながる

研究者たちはまず、アルゴリズムに対する信頼の核心にあるのは、

「仕組みを細部まで知ること」ではなく、

「どう振る舞うかを予測できること」

だと指摘します。

私たちは冷蔵庫の内部構造を知らなくても、

・温度を下げれば冷える

・扉を閉めなければ冷えにくい

といったことは予測できます。

同じように、AIについても、

「この入力をすると、だいたいこういう結果になる」

と分かれば、安心して使えるのです。

人は「心の中のモデル」を使っている

研究では、人がアルゴリズムを理解するとき、頭の中に

メンタルモデル(心的モデル)

と呼ばれる簡易的な理解図を作ると説明します。

これは、アルゴリズムの内部計算を再現するものではありません。

もっと大ざっぱで、

「このAIは、こういう考え方をしていそうだ」

というイメージです。

重要なのは、このメンタルモデルが予測に使えるかどうかです。

予測可能性を決める三つの条件

研究チームは、数多くの先行研究と実験をもとに、

アルゴリズムが予測可能になるための三つの条件を提案しました。

1 利用可能性(Available)

そのアルゴリズムが使っていそうな考え方が、

人にとって思い浮かびやすいかどうか。

例として、

・「いいねの数で並べている」

・「新しい順に並べている」

は、すぐ想像できます。

一方で、

・「投稿者が今日食べたバナナの本数で並べている」

と言われても、普通は思いつきません。

思いつきやすさが高いほど、利用可能性は高くなります。

2 コンパクト性(Compact)

アルゴリズムの考え方が、

ひとつのまとまった概念として把握できるか。

・「人気順」

・「新着順」

・「有害度が高い順」

のように、ひとことで説明できるものはコンパクトです。

逆に、

「いいね×2 − リツイート×5 + 文字数 ÷ 句読点数 + さらに条件分岐」

のように、複数のルールが入り組んでいると、

人は一つのまとまりとして理解しにくくなります。

3 整合性(Aligned)

人が思い描く概念と、

アルゴリズムが実際に行っている処理が一致しているか。

たとえば、

人が「これは有害な投稿だ」と感じるものを、

AIも同じように有害と判断するなら整合しています。

逆に、

人が「問題ない」と思う投稿を、

AIが頻繁に有害と判定するなら、整合していません。

三つがそろったときだけ、予測できる

研究チームの理論は明確です。

利用可能性 × コンパクト性 × 整合性

この三つが同時に満たされるときだけ、

人はアルゴリズムの振る舞いを正確に予測できます。

どれか一つでも欠けると、予測精度は大きく下がります。

大規模実験での検証

研究チームは、1250人を対象に大規模実験を行いました。

参加者には、

・政治関連の投稿が並んだ疑似SNSフィードを見せる

・どんなアルゴリズムかは説明しない

・あとから「この二つの投稿のうち、どちらが上に来ると思うか」を予測させる

という課題を与えました。

アルゴリズムは25種類用意され、

・単純なもの

・複雑なもの

・三条件を満たすもの

・どれかが欠けるもの

が混在しています。

結果:三条件を満たすと正答率85%

結果ははっきりしていました。

三条件を満たすアルゴリズムでは、

平均正答率 約85%

一方、どれか一つでも欠けると、

約54%(ほぼ当てずっぽう)

になります。

しかも、

「単純なアルゴリズム」でも条件を欠くと予測できず、

「大規模言語モデルを使った複雑なアルゴリズム」でも条件を満たせば予測できました。

複雑さそのものは問題ではない

この結果が示すのは、

計算が複雑かどうかと

人が理解できるかどうかは別問題だ、ということです。

人は、

犬と猫を見分けるAIが

内部で何百万個のパラメータを使っていても、

「犬と猫を区別する」

という概念で理解できます。

条件を満たさないとき、人はどうするか

三条件を満たさないアルゴリズムに直面したとき、

人はしばしば

・とりあえず「いいね順だろう」

・たぶん「新しい投稿が優先される」

など、思いつきやすい仮説を使います。

これは必ずしも正しくありませんが、

完全に分からない状態よりはましだからです。

研究者たちは、これを

「利用可能でコンパクトだが、整合していないモデル」

を人が選びがちだと説明します。

なぜ人は間違った理解を維持するのか

研究は、次のような行動も説明します。

・矛盾していても同じ理論を使い続ける

・複数の矛盾した理論を同時に信じる

・他人の説を取り入れる

これは、人が怠けているからではなく、

満足できるモデルが存在しない状況で、何とかやりくりしている

結果だと考えられます。

設計への示唆

研究チームは、今後のアルゴリズム設計に向けて次の方向性を示します。

・内部構造を単純化するだけが解決策ではない

・人が理解しやすい概念に基づく設計が重要

・三条件を満たしているかを事前にチェックできる

つまり、

高性能でありながら、予測可能なAI

は設計可能だということです。

おわりに

この研究が伝えているのは、

「人には高度なAIを理解する力がない」

という悲観ではありません。

むしろ、

人の認知の特徴に合った形で設計すれば、

どんなに複雑なAIでも“わかる存在”になりうる

という希望です。

アルゴリズムの問題は、

人の能力の限界ではなく、

設計思想の問題なのかもしれません。

(出典:arXiv DOI: 10.48550/arXiv.2601.18966)