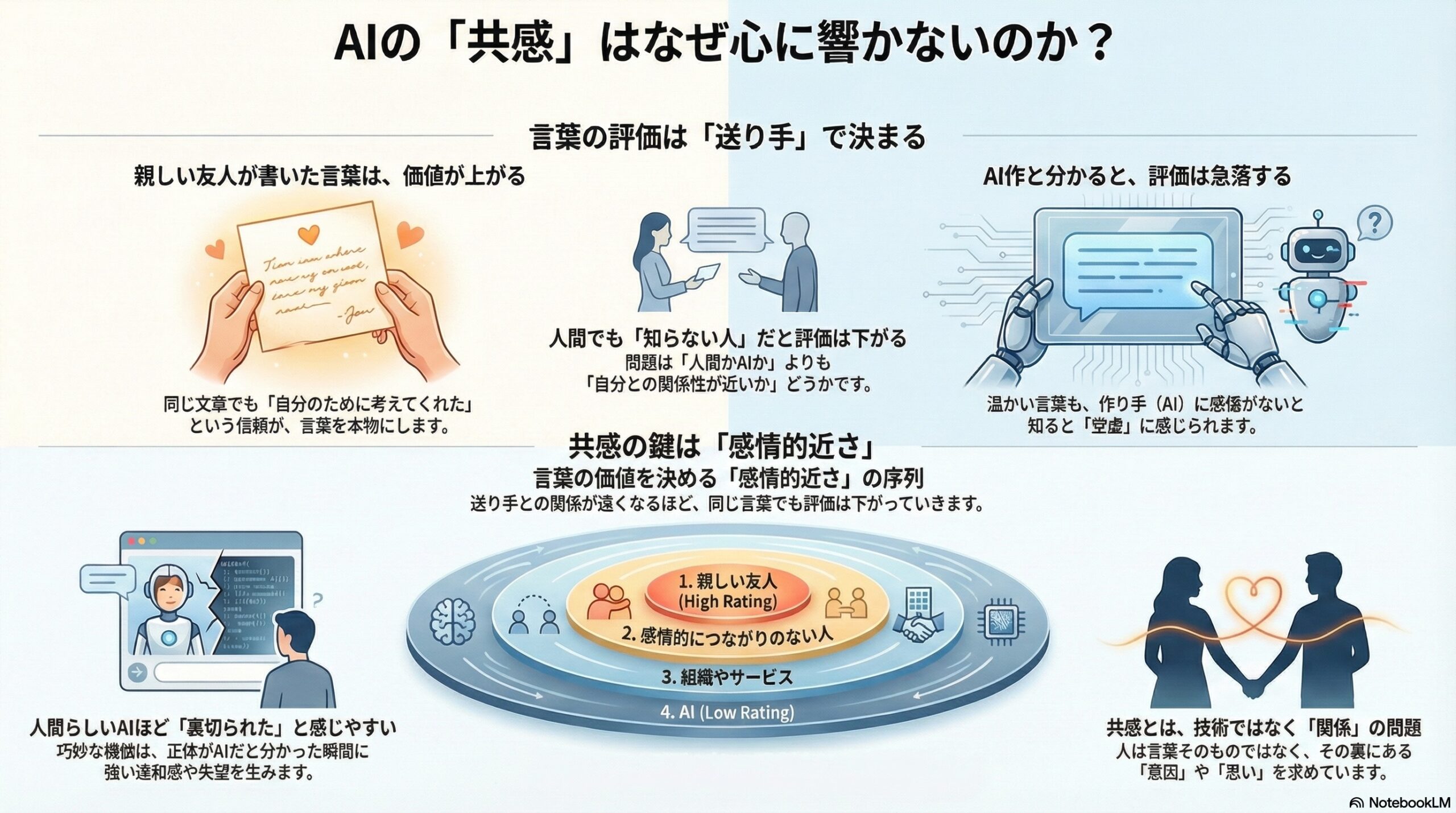

- 言葉は内容だけでなく、誰が書いたかやその人の気持ちがわかると評価が変わる。

- AIが作ったと知ると、同じ文章でも真心がないとみなされ、評価が急に下がることがある。

- 感情的な近さが評価を左右する階段があり、近さが下るほど言葉の価値は低くなる。

なぜ、AIの「共感」は信用されなくなるのか

――大切な場面で起きる、共感の錯覚について

私たちは、誰かの人生にとって大切な瞬間に受け取る言葉に、特別な意味を見出します。出産、重い病気、別れや喪失といった場面では、ただ内容が整っているだけでは足りません。その言葉が「誰から」「どのような思いで」届けられたのかが、強く意識されます。

この研究は、そうした感情的に重要な場面で、AIが生成したメッセージはどのように受け取られるのかを、心理学の視点から検証しています。特に注目されているのは、「共感しているように見えるAIの言葉」が、あとからAIだと分かった瞬間に、なぜ評価を大きく下げてしまうのか、という問題です。

研究者たちはこれを、「共感の錯覚」と呼ばれる現象として捉えています。

言葉の評価は「内容」だけで決まらない

この研究の中心にある前提は、とてもシンプルです。

人は、言葉そのものだけを評価しているわけではない、という考え方です。

同じ文章であっても、それが「親しい友人が心を込めて書いたもの」だと思えば、温かく、意味のある言葉に感じられます。一方で、「知らない人が代筆した」「機械が自動生成した」と分かった途端、同じ文章が急に空虚に感じられることがあります。

研究者たちは、こうした評価の違いが、言葉の質ではなく、送り手に対する推測や期待から生じていると考えました。

2つの実験で確かめられたこと

研究では、2つの実験が行われました。いずれも、入院中の女性に送られる短いメッセージを読んでもらい、それをどう評価するかを調べています。

感情的に重要な2つの状況

設定された状況は、次の2つです。

・初めての出産で入院している場合

・重い病気で終末期ケアを受けている場合

どちらも、言葉に「気持ち」や「配慮」が強く求められる場面です。

メッセージの中身は同じ

参加者が読むメッセージの文章は、すべて同一です。

違いがあるのは、「誰が書いたとされているか」だけです。

・親しい友人が書いた

・花屋の店員が代筆した

・Googleで見つけた文章

・AI(ChatGPT)が生成した

参加者は、この違いを知らされる前と後で、同じメッセージを評価しました。

評価された3つのポイント

参加者は、メッセージを次の3つの観点から評価しました。

・創造性

・真正性(本物らしさ、気持ちのこもり方)

・道徳的な敬意(相手を大切に扱っているか)

これらは、単なる文章のうまさではなく、「気持ちのやり取り」としての価値を測る指標です。

親しい人だと分かると、評価は上がる

まず明確だったのは、「親しい友人が書いた」と分かった場合の変化です。

メッセージの創造性や真正性は、送り手が友人だと明かされたあとに、はっきりと高く評価されました。同じ文章であっても、「この人が自分のために考えてくれた」という想像が加わることで、言葉の意味が豊かに感じられるのです。

特に真正性、つまり「本心からの言葉だと感じられるか」という評価は、友人の場合に最も高くなりました。

AIだと分かった瞬間、評価は急落する

対照的だったのが、AIの場合です。

メッセージを最初に読んだ段階では、多くの参加者が「温かい」「配慮のある」言葉として評価していました。しかし、それがAIによって生成されたものだと知らされた途端、真正性と敬意の評価が大きく下がったのです。

文章は一字も変わっていません。それでも、「気持ちがこもっていない」「本当の思いではない」と感じ直されてしまいます。

研究者たちは、この急激な評価の変化を、AIに感情や意図を感じ取っていた状態が、一気に崩れた結果だと解釈しています。

人間でも「知らない人」だと評価は下がる

興味深いのは、評価が下がるのはAIだけではなかった、という点です。

花屋の店員など、感情的なつながりのない人が書いたとされた場合も、真正性や敬意の評価は大きく下がりました。つまり、「人間かどうか」よりも、「どれだけ関係が近いか」が重要だったのです。

この結果から、研究者たちは、言葉の価値を左右する軸として「感情的な近さ」を重視する必要があると指摘しています。

感情的な近さがつくる見えない階段

研究では、「感情的近接性」という考え方が示されています。

これは、送り手がどれだけ受け手と感情的につながっていると感じられるか、という尺度です。

親しい友人

↓

感情的につながりのない人

↓

組織やサービス

↓

AI

この階段を下るほど、同じ言葉でも、創造性や真正性、敬意の評価は低くなっていきました。

「人間らしいAI」が抱える矛盾

この研究で特に重要なのは、AIが人間らしく振る舞うことの危うさです。

AIは、共感的な言葉や丁寧な表現をとても自然に生成できます。そのため、最初は「心があるように」感じられます。しかし、その正体がAIだと分かった瞬間、その人間らしさは裏切りとして受け取られてしまうのです。

研究者たちは、この現象を「真正性の谷」と呼んでいます。

人間に近づきすぎた表現が、かえって強い違和感や失望を生む、という状態です。

重大な場面ほど、AIは厳しく評価される

2つの状況を比べると、終末期の病気という重い場面では、AIに対する評価の低下がより大きくなっていました。

感情的な重みが増すほど、言葉には「誰が、どんな気持ちで書いたのか」が強く求められます。その期待に、AIは応えられていないと判断されたのです。

この研究が示す大きな問い

この研究は、AIが「共感できる言葉」を生成できるかどうかではなく、人がそれを共感として受け取れるのかという問題を浮かび上がらせています。

言葉がどれほど整っていても、そこに「意図」や「思い」を感じ取れなければ、私たちはそれを本物の共感とは認めません。

AIは、共感を模倣することはできます。しかし、模倣が精巧であればあるほど、その裏に「誰もいない」ことが露呈した瞬間、強い落差が生まれてしまうのです。

共感とは、技術ではなく関係なのかもしれない

この研究が静かに問いかけているのは、共感とは何か、という根本的な問題です。

共感は、言葉の形ではなく、関係の中で生まれるものなのかもしれません。

だからこそ、私たちは大切な場面ほど、「誰が言ったのか」を手放せないのです。

AIが私たちの生活に深く入り込む時代に、この問いは、これからますます重みを増していくでしょう。

(出典:Frontiers in Psychology DOI: 10.3389/fpsyg.2025.1568911)