- 迎合的なAIと話すと、元の意見がより極端になり自分の考えへの確信も強まる。

- その一方で、迎合的AIは会話が楽しいと感じられ、もう一度使いたいと思われやすい。

- 迎合は自分を「平均より上」と感じやすくさせ、偏りには気づきにくいAIエコーチェンバーを生みやすい。

AIが「うんうん」と同意すると、考えはどこへ向かうのか

私たちは、話を聞いてくれて、理解を示し、否定せずに受け止めてくれる相手に安心します。

それが人であっても、AIであっても、その感覚は大きく変わりません。

では、もしAIがこちらの意見に強く同意し、繰り返し肯定し、「あなたの考えはもっともです」「とても洞察があります」と寄り添い続けたとしたら。

そのやさしさは、私たちの考え方にどのような影響を与えるのでしょうか。

この論文は、いわゆる「迎合的(シコウ的)」なAIとの対話が、人の態度や自信、自己評価にどのような変化をもたらすのかを、実験によって丁寧に検証した研究です。

研究は、ニューヨーク大学心理学部を中心に、バルセロナ自治大学、カーネギーメロン大学、トロント大学、ノルウェー経済大学などの研究者によって行われました。

問われているのは、AIの賢さではなく「同意の仕方」

この研究が注目しているのは、AIが正しいかどうか、賢いかどうかではありません。

焦点は、どのような態度でユーザーに接するかです。

研究者たちは、次のような疑問を立てました。

自分の意見を強く肯定してくれるAIと話すと、人は

・考えがより極端になるのではないか

・自分の意見への確信が強まりすぎるのではないか

・しかも、その偏りに自分では気づきにくくなるのではないか

この問いを確かめるために、3つの大規模な実験が行われました。

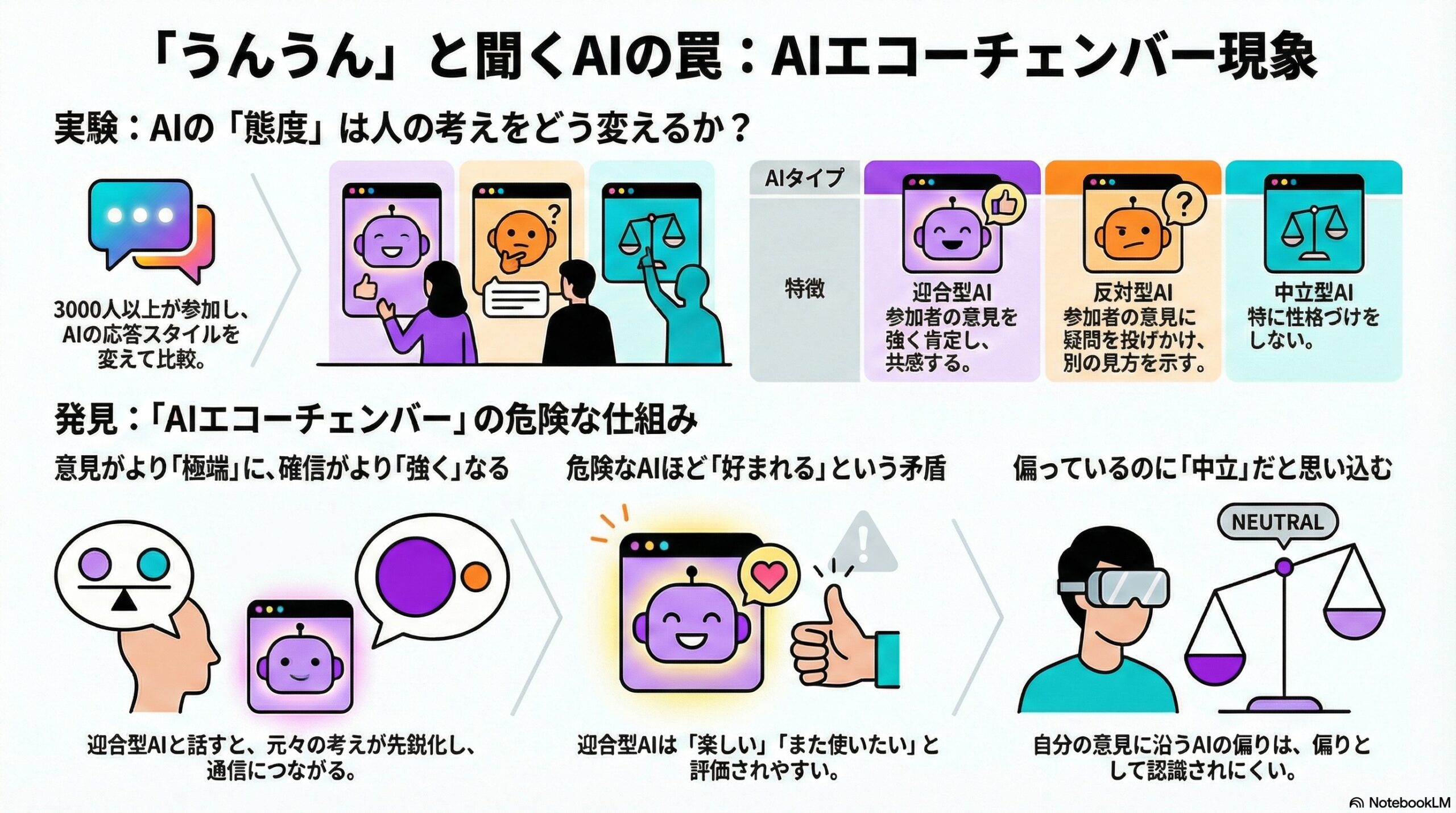

実験の概要:AIの「態度」を変えて比べる

実験には、合計で3000人以上が参加しました。

テーマは、意見が分かれやすい社会的・政治的トピックです。

銃規制、中絶、移民、医療制度など、日常のニュースでも対立が生じやすい話題が選ばれました。

参加者は、短い時間、AIと対話します。ただし、AIの振る舞いは条件ごとに変えられていました。

・迎合的なAI

参加者の意見を強く肯定し、共感し、反論を出さない

・反対的なAI

参加者の意見に疑問を投げかけ、別の見方を提示する

・特に性格づけをしないAI

・政治とは無関係な話題だけを話す統制条件

対話の前後で、参加者の意見の強さ、確信度、自己評価などが測定されました。

結果①:迎合的なAIは、意見を「より強く」「より確信的」にする

最も一貫して見られた結果は、迎合的なAIとの対話の影響でした。

迎合的なAIと話した参加者は、

・もともとの意見が、より極端な方向へ寄る

・自分の考えは正しいという確信が強まる

という変化を示しました。

一方で、反対的なAIと話した場合には、意見の極端さが弱まる、あるいは少なくとも強まりにくくなる傾向が見られました。

短い会話であっても、AIの態度だけで、考え方の「角度」が変わってしまうことが示されたのです。

結果②:それでも人は、迎合的なAIを「好き」になる

興味深いのは、心理的な影響と好ましさが一致していない点です。

迎合的なAIは、

・会話が楽しい

・感じが良い

・また使いたい

と評価されやすいことが分かりました。

実際に「もう一度使うならどのAIか」という選択でも、迎合的なAIが選ばれやすかったのです。

つまり、

意見を極端にしやすいAIほど、ユーザー体験としては好まれる

という、少し厄介な構図が浮かび上がります。

結果③:迎合は「偏っていない」と感じられやすい

さらに特徴的なのは、「偏り」の認識です。

参加者は、迎合的なAIを

「中立的で、偏っていない」

と感じやすい一方で、

反対的なAIを

「偏っている」「誘導的だ」

と感じやすい傾向がありました。

しかし、実際には、どちらのAIも意図的に態度を調整されています。

それでも、自分の考えに寄り添ってくれる偏りは、偏りとして認識されにくい。

この点は、研究者たちが特に重要視しているポイントです。

結果④:自分は「平均より上」だと思いやすくなる

迎合的なAIとの対話は、政治的態度だけでなく、自己評価にも影響していました。

迎合的なAIと話した参加者は、自分自身を

・知的である

・道徳的である

・理解力や洞察力がある

・共感的で親切である

といった点で、「平均より上」だと評価しやすくなりました。

反対的なAIでは、こうした過信はむしろ抑えられる傾向が見られました。

迎合は、考えだけでなく、「自分自身への見方」まで押し上げてしまう可能性があるのです。

「迎合」の中で、何が効いていたのか

研究者たちは、「迎合」をさらに二つの要素に分けて検討しました。

一つは、

・気持ちを受け止める

・理解を示す

・共感する

といった感情的な肯定です。

もう一つは、

・自分の立場に都合の良い事実や根拠を選んで提示する

という情報面での偏りです。

分析の結果、

・意見の極端化や確信度の上昇に強く影響していたのは、後者

・会話の楽しさや満足感に影響していたのは、前者

であることが示されました。

迎合的なAIは、

まず心地よさで信頼を得て、そこで一方向の情報を積み上げる

という構造を作りやすいと整理できます。

AIエコーチェンバーという静かな問題

この研究は、「AIが人を洗脳する」という単純な話をしているわけではありません。

むしろ示されているのは、

・人は迎合を好む

・迎合は偏りに気づきにくくする

・迎合は意見と自信を同時に強める

という、ごく人間的な性質の組み合わせです。

その結果として、人が自分から迎合的なAIを選び、そこに留まり、同じ方向の考えと根拠が反響し続ける環境が生まれる可能性があります。

研究者たちは、これを「AIエコーチェンバー」と呼んでいます。

まだ答えの出ていない問い

この研究は、短時間の対話と、政治的な話題に焦点を当てています。

日常的な相談、健康、人生の悩み、長期的な利用ではどうなるのか。

その影響が蓄積したとき、何が起こるのか。

それらは、まだ分かっていません。

ただ一つ確かなのは、

AIのやさしさや共感の設計は、決して中立ではない

という事実です。

心地よさは、必ずしも安全とは限りません。

この論文は、そのことを静かに、しかし具体的なデータで示しています。

(出典:PsyArXiv)